0 Comments

·0 Shares

·57 Views

·0 Reviews

-

0 Comments ·0 Shares ·68 Views ·0 Reviews

-

1. 关于DeepSeek的潜力

DeepSeek虽暂不及英伟达与台积电,但其在AI芯片架构上展现了潜力。中国在AI芯片研发上投入巨大,如寒武纪、华为昇腾系列均取得突破,显示中国具备原创能力,而非仅靠模仿。

2. 关于造假问题

个别造假事件不能代表整体科研水平。清华在2022年Nature指数中排名全球第一,中国科研论文数量连续多年全球第一。这些成就说明中国科研生态已具备全球竞争力。

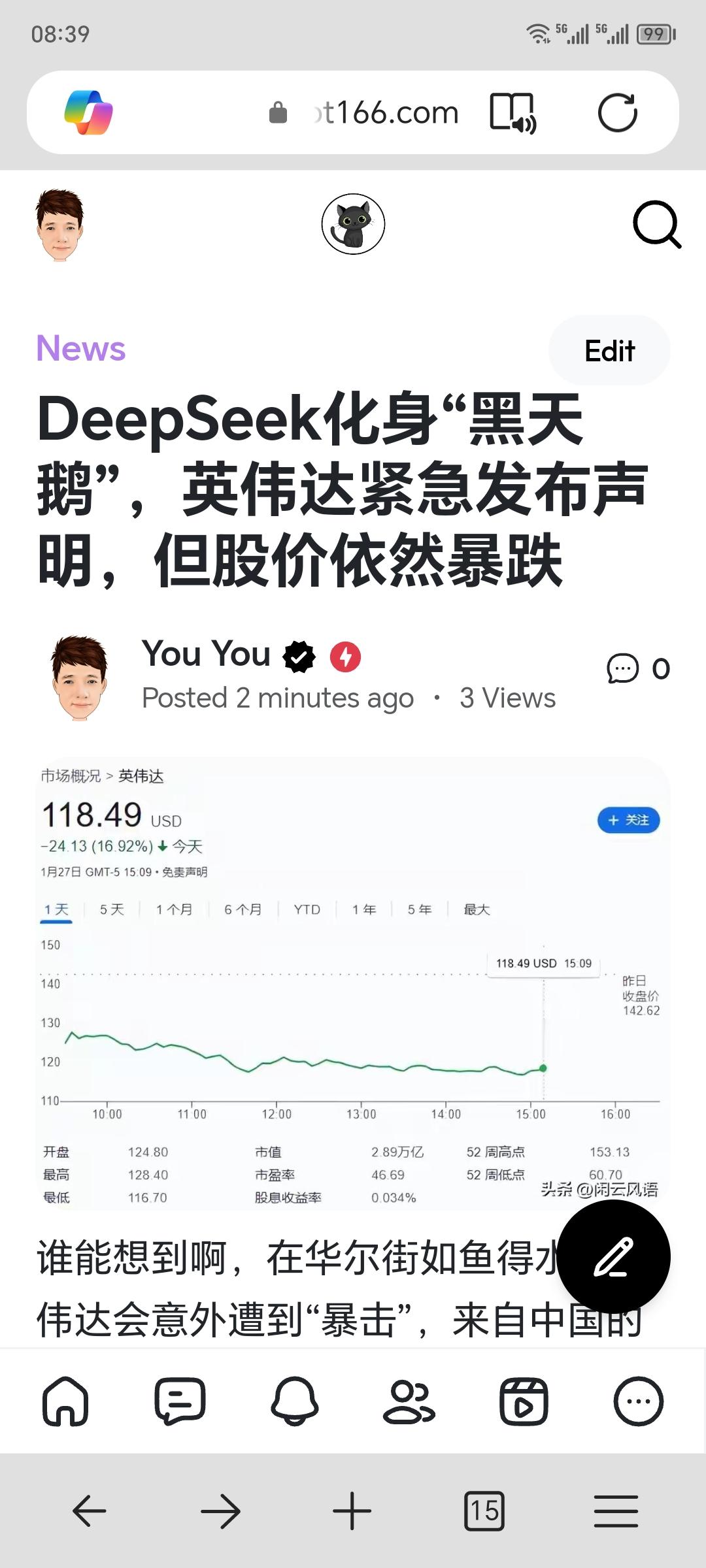

3. 台积电与英伟达股价波动

股价波动更多因估值较高与市场情绪。尽管中国厂商如中芯国际崛起短期难撼动台积电,但中国在半导体供应链上的投入(全球设备采购占比33%)体现了长期布局。

4. 中国科技能否超越美国

在5G、无人机、光伏等领域,中国已全球领先,如光伏组件出货量占全球70%以上。虽在高端芯片领域存在差距,但差距逐步缩小,华为5G专利数领先美国即为典型案例。

中国科技发展不可低估,DeepSeek虽短期难威胁英伟达与台积电,但长期潜力值得重视。在投资上,与其过度担忧,不如关注趋势,把握机遇。1. 关于DeepSeek的潜力 DeepSeek虽暂不及英伟达与台积电,但其在AI芯片架构上展现了潜力。中国在AI芯片研发上投入巨大,如寒武纪、华为昇腾系列均取得突破,显示中国具备原创能力,而非仅靠模仿。 2. 关于造假问题 个别造假事件不能代表整体科研水平。清华在2022年Nature指数中排名全球第一,中国科研论文数量连续多年全球第一。这些成就说明中国科研生态已具备全球竞争力。 3. 台积电与英伟达股价波动 股价波动更多因估值较高与市场情绪。尽管中国厂商如中芯国际崛起短期难撼动台积电,但中国在半导体供应链上的投入(全球设备采购占比33%)体现了长期布局。 4. 中国科技能否超越美国 在5G、无人机、光伏等领域,中国已全球领先,如光伏组件出货量占全球70%以上。虽在高端芯片领域存在差距,但差距逐步缩小,华为5G专利数领先美国即为典型案例。 中国科技发展不可低估,DeepSeek虽短期难威胁英伟达与台积电,但长期潜力值得重视。在投资上,与其过度担忧,不如关注趋势,把握机遇。0 Comments ·0 Shares ·94 Views ·0 Reviews -

· 0 Comments ·0 Shares ·98 Views ·0 Reviews1

-

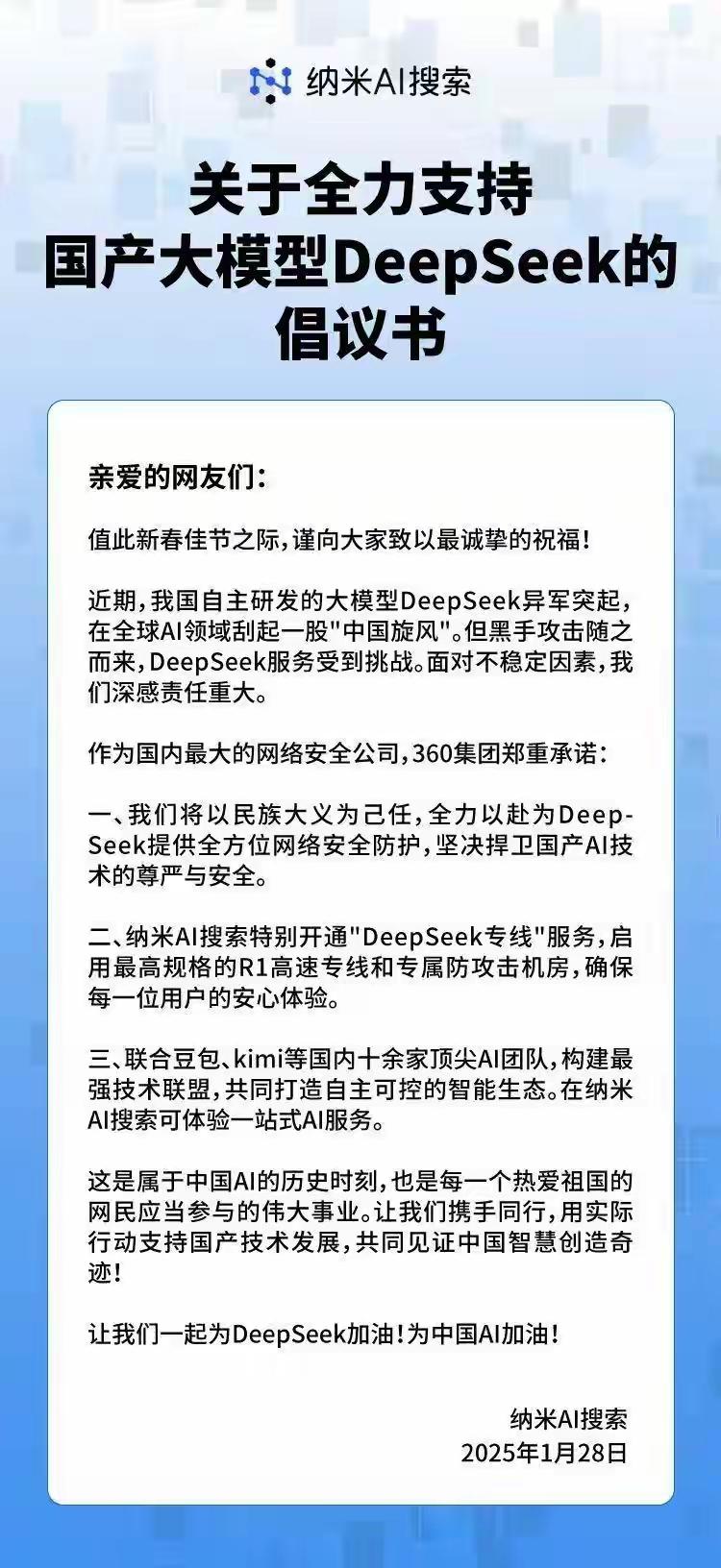

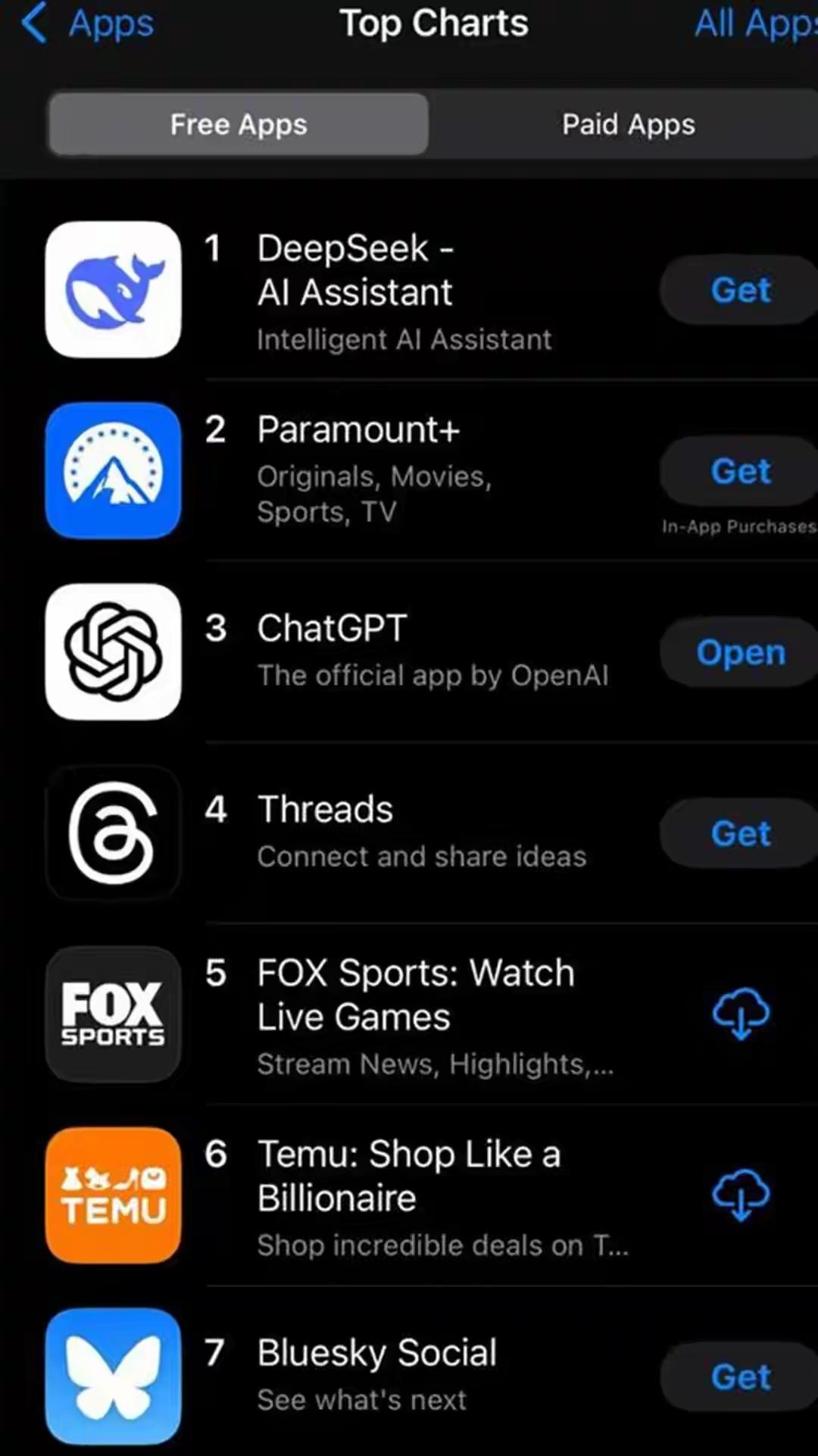

DeepSeek-R1发布后全世界都忙疯了,这可不是中国逼他们的,因为最终他们发现,中国人用更少的资源搞出了比美国任何一个大模型都优秀的AI,账目对不上了,各大AI投资人都在担心自己花出去的千亿美元资金能不能收回本金的问题!DeepSeek-R1发布后全世界都忙疯了,这可不是中国逼他们的,因为最终他们发现,中国人用更少的资源搞出了比美国任何一个大模型都优秀的AI,账目对不上了,各大AI投资人都在担心自己花出去的千亿美元资金能不能收回本金的问题!0 Comments ·0 Shares ·91 Views ·0 Reviews

-

星期一美国股市大震撼

盘前交易股价

辉达和台积电股价下杀10%以上

美国科技股像遭到大地震袭击

大杀盘的原因只有一个

美国几家专业及学术机构认证

最新出炉的AI模型

「深寻」或「深度求索」DeepSeek

与OpenAI的ChatGPT较量

有过之而无不及

OpenAI的ChatGPT要使用

大量昂贵的辉达AI晶片

要用台积电的高端制程

要花费钜资盖豪华的算力中心

还要耗尽庞大的电力

更令人讶异的是

DeepSeek都不需要

不需要昂贵的辉达AI晶片

所以辉达股价下挫

也不需要台积电的高端制程

所以台积电股价下杀

原本ChatGPT开创出来的

演算法已经走在AI前沿

打败Google和Amazon的AI演算法

带着辉达和台积电风光了两年

没想到DeepSeek横空出世

开创出来另一条AI模型新捷径

目前被认定可能会像

抖音把YT挤到老二那样子

DeepSeek把ChapGPT挤到老二

连带拉AMD和华为

让辉达无法唯我独尊

更让拜登和雷蒙多这两个蠢货

要遏止中国AI的念头成了一场白日梦

DeepSeek 的设计者是一群

北京大学和清华大学的博士

这下子有好戏看了

中美竞争刚开始

美国认为不卖辉达晶片给中国

中国的AI就没搞头

虽然中国晶片目前还输美国

美国没料到中国却在AI模型硬超车

看看美国还有什么法宝

可以遏制中国的AI?星期一美国股市大震撼 盘前交易股价 辉达和台积电股价下杀10%以上 美国科技股像遭到大地震袭击 大杀盘的原因只有一个 美国几家专业及学术机构认证 最新出炉的AI模型 「深寻」或「深度求索」DeepSeek 与OpenAI的ChatGPT较量 有过之而无不及 OpenAI的ChatGPT要使用 大量昂贵的辉达AI晶片 要用台积电的高端制程 要花费钜资盖豪华的算力中心 还要耗尽庞大的电力 更令人讶异的是 DeepSeek都不需要 不需要昂贵的辉达AI晶片 所以辉达股价下挫 也不需要台积电的高端制程 所以台积电股价下杀 原本ChatGPT开创出来的 演算法已经走在AI前沿 打败Google和Amazon的AI演算法 带着辉达和台积电风光了两年 没想到DeepSeek横空出世 开创出来另一条AI模型新捷径 目前被认定可能会像 抖音把YT挤到老二那样子 DeepSeek把ChapGPT挤到老二 连带拉AMD和华为 让辉达无法唯我独尊 更让拜登和雷蒙多这两个蠢货 要遏止中国AI的念头成了一场白日梦 DeepSeek 的设计者是一群 北京大学和清华大学的博士 这下子有好戏看了 中美竞争刚开始 美国认为不卖辉达晶片给中国 中国的AI就没搞头 虽然中国晶片目前还输美国 美国没料到中国却在AI模型硬超车 看看美国还有什么法宝 可以遏制中国的AI?· 0 Comments ·0 Shares ·64 Views ·0 Reviews1

-

高盛集團(Goldoldman Sachs)1月24日發布最新《機構經紀業務專報》顯示,全球避險基金正加速撤離科技類股部位。根據路透社獨家取得該份涵蓋1月17日至24日交易數據的報告,這波資金轉移已從核心科技板塊擴散至相關基礎設施產業,包括資料中心營運商與電動車充電網絡開發商等「算力基建概念股」。

這份重量級市場分析指出,儘管AI技術突破持續為電力供應與能源系統升級產業帶來「綠色溢價」,但機構投資人正重新評估美國科技業的戰略價值。值得關注的是,避險基金單周淨賣出額創下去年第四季以來新高,其中半導體設備與雲端服務類股遭減持幅度最為顯著。

「當中國深度求索(DeepSeek)這類新創能以十分之一成本開發出同級AI模型,華爾街不得不質疑矽谷的技術壟斷能否持續。」艾倫資本管理公司(Erlen Capital Management)董事總經理布魯諾·施奈勒(Bruno Schneller)接受訪問時強調,美國科技產業雖坐擁年均2,300億美元的AI投資規模,但在全球競爭版圖中首度出現結構性挑戰。

市場觀察家指出,這波撤資潮恰逢美國聯邦通訊委員會(FCC)重審科技巨頭數據壟斷條款之際,投資機構正透過「超前部署」策略,將部分資金轉進再生能源與智慧電網等具政策紅利的概念股。高盛報告特別點名北美三大區域電網運營商,近期機構持股比例逆勢增長達18%,反映市場對AI算力基礎建設的長期押注高盛集團(Goldoldman Sachs)1月24日發布最新《機構經紀業務專報》顯示,全球避險基金正加速撤離科技類股部位。根據路透社獨家取得該份涵蓋1月17日至24日交易數據的報告,這波資金轉移已從核心科技板塊擴散至相關基礎設施產業,包括資料中心營運商與電動車充電網絡開發商等「算力基建概念股」。 這份重量級市場分析指出,儘管AI技術突破持續為電力供應與能源系統升級產業帶來「綠色溢價」,但機構投資人正重新評估美國科技業的戰略價值。值得關注的是,避險基金單周淨賣出額創下去年第四季以來新高,其中半導體設備與雲端服務類股遭減持幅度最為顯著。 「當中國深度求索(DeepSeek)這類新創能以十分之一成本開發出同級AI模型,華爾街不得不質疑矽谷的技術壟斷能否持續。」艾倫資本管理公司(Erlen Capital Management)董事總經理布魯諾·施奈勒(Bruno Schneller)接受訪問時強調,美國科技產業雖坐擁年均2,300億美元的AI投資規模,但在全球競爭版圖中首度出現結構性挑戰。 市場觀察家指出,這波撤資潮恰逢美國聯邦通訊委員會(FCC)重審科技巨頭數據壟斷條款之際,投資機構正透過「超前部署」策略,將部分資金轉進再生能源與智慧電網等具政策紅利的概念股。高盛報告特別點名北美三大區域電網運營商,近期機構持股比例逆勢增長達18%,反映市場對AI算力基礎建設的長期押注· 0 Comments ·0 Shares ·73 Views ·0 Reviews1

-

中國人工智慧新創公司DeepSeek憑藉低成本、高效能的大語言模型強勢崛起,近日在國際市場投下震撼彈,掀起全球對美國AI技術主導地位的質疑聲浪。受此衝擊,美股三大指數今(25)日開盤全面重挫,半導體類股更成重災區,輝達(NVIDIA)股價盤初暴跌逾3%,引發市場高度關注。

▌美股開盤速報

道瓊工業指數:下跌275.4點(跌幅0.62%),報44,148.84點

標普500指數:重挫132.2點(跌幅2.17%),報5,969.04點

那斯達克綜合指數:暴跌720.3點(跌幅3.61%),報19,234.04點

▌科技股領跌 晶片巨頭承壓

以AI晶片龍頭輝達為首的半導體族群首當其衝,分析師指出,DeepSeek透過演算法優化大幅降低運算資源需求,若此技術趨勢擴散,恐削弱市場對高階晶片的依賴。值得注意的是,DeepSeek成立僅一年即憑開源策略快速滲透市場,其模型效能直逼國際大廠卻僅需1/10訓練成本,技術突破令業界咋舌。

▌產業衝擊波持續發酵

儘管DeepSeek尚未公佈商業化具體規劃,但其技術路線已撼動資本市場信心。華爾街交易員透露,部分機構投資人正重新評估AI硬體供應鏈的長期前景,導致相關類股遭逢獲利了結賣壓。市場關注本週將公佈的企業財報與聯準會政策會議,能否為科技股注入止跌動能。中國人工智慧新創公司DeepSeek憑藉低成本、高效能的大語言模型強勢崛起,近日在國際市場投下震撼彈,掀起全球對美國AI技術主導地位的質疑聲浪。受此衝擊,美股三大指數今(25)日開盤全面重挫,半導體類股更成重災區,輝達(NVIDIA)股價盤初暴跌逾3%,引發市場高度關注。 ▌美股開盤速報 道瓊工業指數:下跌275.4點(跌幅0.62%),報44,148.84點 標普500指數:重挫132.2點(跌幅2.17%),報5,969.04點 那斯達克綜合指數:暴跌720.3點(跌幅3.61%),報19,234.04點 ▌科技股領跌 晶片巨頭承壓 以AI晶片龍頭輝達為首的半導體族群首當其衝,分析師指出,DeepSeek透過演算法優化大幅降低運算資源需求,若此技術趨勢擴散,恐削弱市場對高階晶片的依賴。值得注意的是,DeepSeek成立僅一年即憑開源策略快速滲透市場,其模型效能直逼國際大廠卻僅需1/10訓練成本,技術突破令業界咋舌。 ▌產業衝擊波持續發酵 儘管DeepSeek尚未公佈商業化具體規劃,但其技術路線已撼動資本市場信心。華爾街交易員透露,部分機構投資人正重新評估AI硬體供應鏈的長期前景,導致相關類股遭逢獲利了結賣壓。市場關注本週將公佈的企業財報與聯準會政策會議,能否為科技股注入止跌動能。· 0 Comments ·0 Shares ·69 Views ·0 Reviews1

-

#全球掀起deepseek复现狂潮硅谷巨头神话崩塌0 Comments ·0 Shares ·61 Views ·0 Reviews